Sitemap là một sơ đồ của một website, bao gồm tất cả các link bài viết, chuyên mục của trang web. Công việc của sitemap khai báo cho con Bot lên các công cụ tìm kiếm Google Search Console, Yahoo Index, Bing Index, Cốc cốc Search,…

Trang web của bạn thực sự lớn

Trang web mới hoạt động gần đây và có ít đường liên kết ngoài đến trang đó

Trang web của bạn có một kho lưu trữ lớn gồm các trang nội dung bị tách riêng hoặc không liên kết với nhau.

Trang web có nhiều nội dung đa phương tiện (video, hình ảnh) hoặc đang hiển thị trong Google Tin tức

Google hỗ trợ nhiều định dạng sơ đồ trang web:

Mọi định dạng gửi cho Google đều phải theo giao thức sơ đồ trang web chuẩn. Hiện tại, Google sẽ bỏ qua thuộc tính <priority> trong sơ đồ trang web.

Đối với mọi định dạng, một sơ đồ trang web chỉ được phép có kích thước tối đa là 50 MB (khi chưa nén) và chứa không quá 50.000 URL. Nếu có nhiều URL hơn hoặc tệp lớn hơn, bạn sẽ phải tách danh sách trang của mình thành nhiều sơ đồ trang web. Bạn cũng có thể chọn cách tạo một tệp chỉ mục sơ đồ trang web (tệp này trỏ đến một danh sách sơ đồ trang web) rồi gửi tệp chỉ mục đó cho Google. Bạn có thể gửi nhiều sơ đồ trang web và/hoặc nhiều tệp chỉ mục sơ đồ trang web cho Google.

Dùng các URL nhất quán và đủ điều kiện. Google sẽ thu thập dữ liệu các URL của bạn đúng như những gì có trong danh sách. Ví dụ: Nếu trang web của bạn có địa chỉ là https://www.example.com/, đừng nêu ra URL là https://example.com/ (thiếu www) hoặc ./mypage.html (URL tương đối).

Bạn có thể đăng sơ đồ trang web ở bất cứ đâu trên trang web của mình, nhưng sơ đồ trang web chỉ tác động đến các thư mục con thuộc thư mục mẹ. Sơ đồ trang web đăng tại thư mục gốc có thể tác động đến mọi tệp trên trang web. Vì vậy, thư mục gốc của trang web chính là nơi bạn nên đăng sơ đồ trang web.

Không đưa mã nhận dạng phiên trong URL vào sơ đồ trang web. Điều này giúp giảm tình trạng thu thập dữ liệu nội dung trùng lặp trên những URL đó.

Thông báo cho Google về các phiên bản ngôn ngữ thay thế nhau của một URL bằng thẻ chú thích hreflang.

Tệp sơ đồ trang web phải được mã hóa bằng phương thức UTF-8 và dùng mã thoát dành cho URL một cách thích hợp.

Chia nhỏ sơ đồ trang web lớn thành các sơ đồ trang web nhỏ: một sơ đồ trang web có thể chứa tối đa 50.000 URL và không được vượt quá 50MB khi chưa nén. Dùng một tệp chỉ mục sơ đồ trang web để liệt kê hết các sơ đồ trang web rồi gửi tệp này cho Google thay vì gửi từng sơ đồ trang web riêng lẻ.

Chỉ liệt kê các URL chính tắc trong sơ đồ trang web của bạn. Nếu một trang có hai phiên bản thì trong sơ đồ trang web, hãy chỉ liệt kê phiên bản bạn muốn xuất hiện trong kết quả tìm kiếm. Nếu trang web của bạn có hai phiên bản (ví dụ: phiên bản có www và phiên bản không có www), hãy chọn trang web bạn ưu tiên và đặt sơ đồ trang web ở đó rồi thêm rel=canonical hoặc lệnh chuyển hướng trên trang web còn lại.

Nếu một trang có các URL riêng cho phiên bản dành cho thiết bị di động và phiên bản dành cho máy tính, thì sơ đồ trang web chỉ nên trỏ đến một phiên bản. Tuy nhiên, nếu bạn muốn trỏ đến cả hai URL, hãy chú thích các URL đó để chỉ rõ phiên bản dành cho máy tính và phiên bản dành cho thiết bị di động.

Dùng phần mở rộng của sơ đồ trang web để trỏ đến các loại nội dung đa phương tiện khác như video, hình ảnh và tin tức.

Nếu có các trang thay thế nhau cho từng ngôn ngữ hoặc khu vực, bạn có thể sử dụng hreflang trong sơ đồ trang web hoặc trong thẻ html để chỉ rõ các URL thay thế.

Ký tự không phải chữ/số và ký tự không thuộc hệ chữ Latinh. Chúng tôi yêu cầu tệp sơ đồ trang web của bạn phải được mã hoá bằng phương thức UTF-8 (thường thì bạn có thể thực hiện việc này khi lưu tệp). Cũng như với mọi tệp XML, tất cả giá trị dữ liệu (kể cả URL) đều phải sử dụng mã thoát của thực thể cho những ký tự liệt kê trong bảng dưới đây. Sơ đồ trang web chỉ có thể chứa ký tự ASCII, không được chứa ký tự ASCII mở rộng hoặc một số mã điều khiển hay ký tự đặc biệt như * và {}. Nếu URL trong sơ đồ trang web của bạn chứa những ký tự này, bạn sẽ gặp lỗi khi cố gắng thêm URL đó.

| Ký tự | Biểu tượng | Mã thoát |

|

Ký hiệu & |

& |

& |

|

Dấu nháy đơn |

' |

' |

|

Dấu nháy kép |

" |

" |

|

Dấu lớn hơn |

> |

> |

|

Dấu nhỏ hơn |

< |

< |

Ngoài ra, tất cả URL (kể cả URL của sơ đồ trang web) đều phải dùng mã thoát dành cho URL và phải được mã hoá sao cho máy chủ web lưu trữ những URL đó có thể đọc được. Tuy nhiên, nếu bạn sử dụng các loại tập lệnh, công cụ hoặc tệp nhật ký để tạo URL (bất kỳ phương thức nào khác ngoài cách nhập thủ công URL) thì thông thường, công đoạn này đã được hoàn thành sẵn cho bạn. Nếu bạn gửi sơ đồ trang web và gặp phải lỗi cho biết Google không thể tìm thấy một số URL, hãy kiểm tra để chắc chắn các URL của bạn tuân thủ chuẩn RFC-3986 cho URI, chuẩn RFC-3987 cho IRI và chuẩn XML.

Việc tạo sơ đồ trang web giúp bạn thông báo cho công cụ tìm kiếm biết những URL nào bạn muốn ưu tiên xuất hiện trong kết quả tìm kiếm. Đó là các URL chính tắc. Nếu bạn có nhiều URL cùng dẫn tới nội dung giống nhau, hãy chọn URL mà bạn ưu tiên và đưa URL đó vào sơ đồ trang web thay vì đưa tất cả những URL dẫn tới cùng một nội dung.

Khi bạn đã xác định được URL nên đưa vào sơ đồ trang web, hãy chọn một trong những cách sau đây để tạo sơ đồ trang web (tùy thuộc vào kích thước và cấu trúc trang web của bạn):

Để CMS tạo sơ đồ trang web giúp bạn.

Đối với những sơ đồ trang web không có quá nhiều URL, bạn có thể tạo sơ đồ trang web theo cách thủ công.

Đối với những sơ đồ trang web có rất nhiều URL, bạn hãy tạo sơ đồ trang web theo cách tự động.

Google không kiểm tra sơ đồ trang web mỗi lần thu thập dữ liệu từ một trang web. Chúng tôi chỉ kiểm tra sơ đồ trang web khi lần đầu tiên phát hiện sơ đồ đó và chỉ kiểm tra lại khi bạn thông báo cho chúng tôi rằng sơ đồ đó đã thay đổi. Hãy thông báo cho Google về một sơ đồ trang web chỉ khi bạn tạo sơ đồ mới hoặc cập nhật sơ đồ hiện có. Đừng gửi hoặc thông báo cho Google nhiều lần về một sơ đồ trang web không có thay đổi.

Nếu bạn đã cập nhật một số trang trong sơ đồ trang web, hãy đánh dấu những trang đó bằng thuộc tính <lastmod>. Các tệp XML khác cũng có trường tương tự, chẳng hạn như <updated> đối với Atom XML. Bạn cũng có thể tìm hiểu cách tính ngày này.

Có một số cách để cung cấp sơ đồ trang web của bạn cho Google:

Gửi sơ đồ trang web bằng báo cáo Sơ đồ trang web.

Sử dụng công cụ ping. Gửi yêu cầu GET trong trình duyệt hoặc dòng lệnh đến địa chỉ sau đây, trong đó chỉ định URL đầy đủ của sơ đồ trang web. Bạn cần chắc chắn rằng tệp sơ đồ trang web có thể truy cập được: https://www.google.com/ping?sitemap=FULL_URL_OF_SITEMAP

Ví dụ: https://www.google.com/ping?sitemap=https://example.com/sitemap.xml

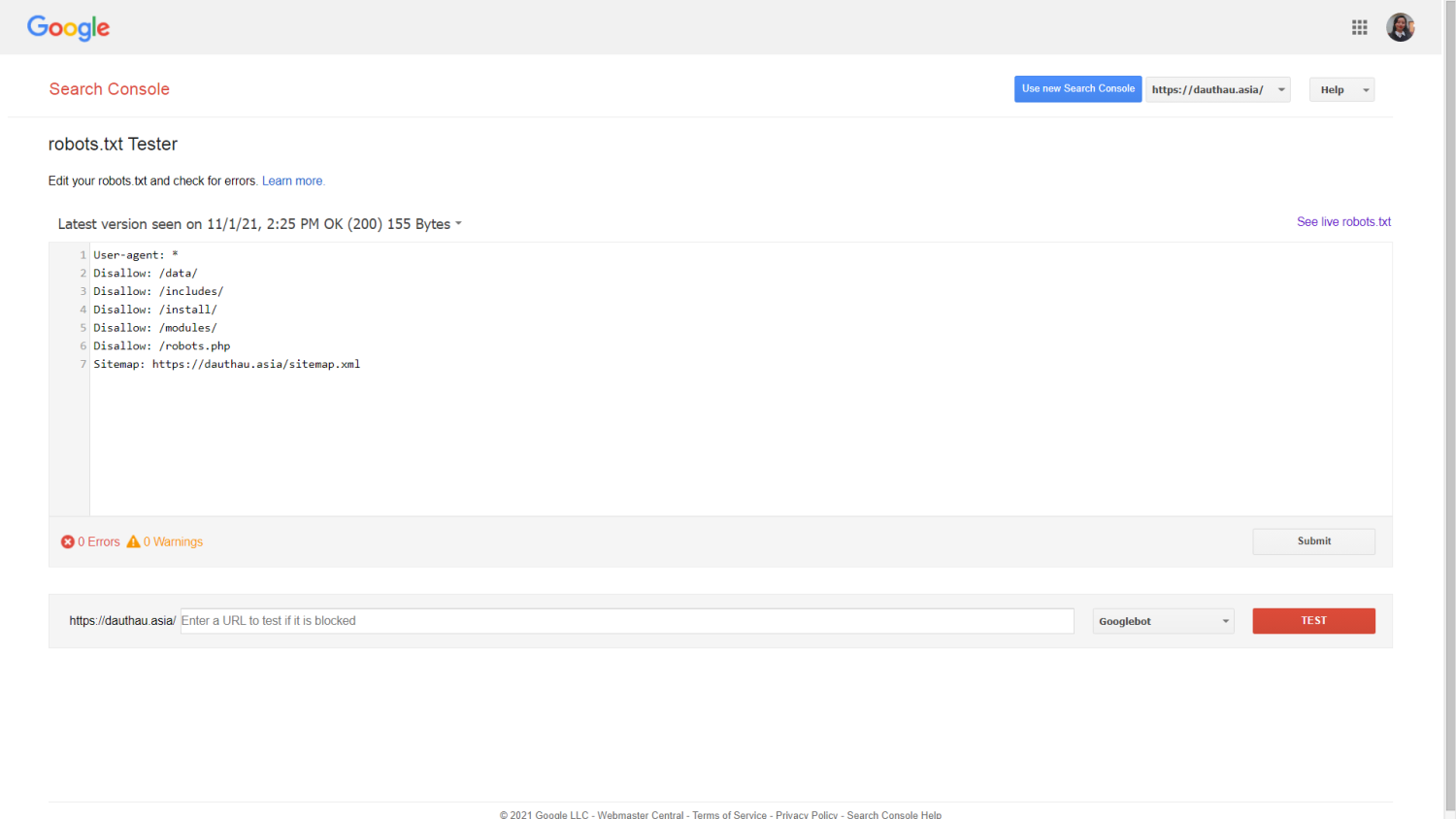

Chèn dòng sau vào vị trí bất kỳ trong tệp robots.txt để chỉ định đường dẫn đến sơ đồ trang web. Chúng tôi sẽ tìm dòng này vào lần tiếp theo chúng tôi thu thập dữ liệu tệp robots.txt của bạn.

Sitemap: https://example.com/my_sitemap.xml

Dùng WebSub nếu bạn sử dụng Atom/RSS cho sơ đồ trang web và muốn thông báo về thay đổi của bạn cho các công cụ tìm kiếm khác ngoài Google.

Tệp robots.txt cho trình thu thập dữ liệu của công cụ tìm kiếm biết có thể truy cập vào những URL nào trên trang web của bạn. Tệp này chủ yếu dùng để ngăn trình thu thập dữ liệu gửi quá nhiều yêu cầu cho trang web; đây không phải là cơ chế để ẩn một trang web khỏi Google. Để ẩn một trang web khỏi Google, hãy chặn lập chỉ mục bằng noindex hoặc bảo vệ trang đó bằng mật khẩu.

Tệp robots.txt chủ yếu dùng để quản lý lưu lượng truy cập của trình thu thập dữ liệu vào trang web của bạn và thường dùng để ẩn một tệp khỏi Google, tùy thuộc vào loại tệp.

Trước khi tạo hoặc chỉnh sửa tệp robots.txt, bạn nên biết những hạn chế của phương pháp chặn URL này. Tùy thuộc vào mục tiêu và tình huống của bạn, bạn nên cân nhắc những cơ chế khác để đảm bảo URL của bạn không tìm được trên web.

Một số công cụ tìm kiếm có thể không hỗ trợ các lệnh trong tệp robots.txt.

Hướng dẫn trong các tệp robots.txt không thể bắt một trình thu thập dữ liệu làm theo một hành vi cụ thể. Trình thu thập dữ liệu có quyền quyết định việc có tuân theo lệnh trong tệp hay không. Googlebot và các trình thu thập dữ liệu web có uy tín khác tuân thủ hướng dẫn trong tệp robots.txt, tuy nhiên, một số trình thu thập dữ liệu khác có thể không như vậy. Vì vậy, nếu bạn muốn đảm bảo an toàn cho thông tin của mình trước các trình thu thập dữ liệu web, bạn nên dùng những phương thức chặn khác, chẳng hạn như bảo vệ các tệp riêng tư bằng mật khẩu trên máy chủ.

Mỗi trình thu thập dữ liệu sẽ phân tích cú pháp theo những cách riêng.

Các trình thu thập dữ liệu web có uy tín sẽ tuân theo các lệnh trong tệp robots.txt, tuy nhiên, có thể mỗi trình thu thập dữ liệu lại có cách thức riêng để diễn giải các lệnh. Bạn nên nắm được cú pháp thích hợp dành cho từng trình thu thập dữ liệu web vì một số trình thu thập có thể không hiểu được một số hướng dẫn nhất định.

Một trang bị tệp robots.txt chặn vẫn có thể được lập chỉ mục nếu có trang web khác liên kết đến trang đó.

Google sẽ không thu thập dữ liệu hoặc lập chỉ mục nội dung bị tệp robots.txt chặn, tuy nhiên, chúng tôi vẫn có thể tìm thấy và lập chỉ mục một URL bị tệp robots.txt chặn khi có những nơi khác liên kết đến URL đó. Kết quả là các địa chỉ URL và có thể là cả thông tin công khai khác như văn bản liên kết trong các đường liên kết đến trang vẫn sẽ xuất hiện trong kết quả tìm kiếm trên Google. Để ngăn URL của bạn xuất hiện trong kết quả tìm kiếm trên Google, hãy bảo vệ các tệp trên máy chủ bằng mật khẩu, dùng thẻ meta noindex hoặc tiêu đề phản hồi hoặc xóa toàn bộ trang.

Sử dụng Google Search Console: https://www.google.com/webmasters/tools/robots-testing-tool

Bạn có thể sử dụng hầu hết mọi trình chỉnh sửa văn bản để tạo tệp robots.txt. Ví dụ: Notepad, TextEdit, vi và emacs có thể tạo các tệp robots.txt hợp lệ.

Đừng dùng trình xử lý văn bản vì trình xử lý văn bản thường lưu tệp dưới một định dạng độc quyền và có thể thêm những ký tự không mong muốn (chẳng hạn như dấu ngoặc kép cong); việc này có thể khiến trình thu thập dữ liệu gặp sự cố. Hãy nhớ lưu tệp bằng phương thức mã hóa UTF-8 nếu được nhắc trong hộp thoại lưu tệp.

Phải đặt tên tệp là robots.txt.

Trang web của bạn chỉ có thể có một tệp robots.txt.

Tệp robots.txt phải nằm ở thư mục gốc trên máy chủ của trang web, tương ứng với phạm vi áp dụng của tệp. Ví dụ: để kiểm soát quá trình thu thập dữ liệu trên mọi URL tại https://www.example.com/, tệp robots.txt phải nằm tại https://www.example.com/robots.txt. Bạn không thể đặt tệp này trong một thư mục con (ví dụ như tại https://example.com/pages/robots.txt). Nếu bạn không chắc chắn về cách truy cập vào thư mục gốc của trang web hoặc cần quyền truy cập, hãy liên hệ với nhà cung cấp dịch vụ lưu trữ web. Nếu bạn không thể truy cập vào thư mục gốc của trang web, hãy dùng một phương thức chặn thay thế, chẳng hạn như thẻ meta.

Tệp robots.txt có thể áp dụng cho các miền con (ví dụ: https://website.example.com/robots.txt) hoặc trên các cổng không chuẩn (ví dụ: http://example.com:8181/robots.txt).

Tệp robots.txt phải là tệp văn bản được mã hóa UTF-8 (bao gồm cả ASCII). Google có thể bỏ qua các ký tự không thuộc phạm vi của UTF-8 vì các quy tắc trong tệp robots.txt có thể hiển thị không chính xác.

Ngoài ra bạn có thể tham khảo thêm nội dung này tại: SITE MAP & ROBOTS.TXT - PHÂN TÍCH HIỆN TRẠNG WEBSITE

Những tin mới hơn

Những tin cũ hơn

![[Mời thầu] Gói thầu số 3: Kiểm thử phần mềm](/assets/news/2024_04/kiem-thu-phan-mem.png) [Mời thầu] Gói thầu số 3: Kiểm thử phần mềm

[Mời thầu] Gói thầu số 3: Kiểm thử phần mềm

![[Mời thầu] Bảo trì phần mềm quản trị trường học](/assets/news/2024_04/bao-tri-phan-mem-quan-tri-truong-hoc.png) [Mời thầu] Bảo trì phần mềm quản trị trường học

[Mời thầu] Bảo trì phần mềm quản trị trường học

![[Mời thầu] Thuê ngoài Dịch vụ phát triển phần mềm Hệ thống quản lý văn bản điện tử phục vụ nâng cấp SPDV](/assets/news/2024_04/thue-ngoai-dich-vu-phat-trien-phan-mem-he-thong-quan-ly-van-ban-dien-tu-phuc-vu-nang-cap-spdv.png) [Mời thầu] Thuê ngoài Dịch vụ phát triển phần mềm Hệ thống quản lý văn bản điện tử phục vụ nâng cấp SPDV

[Mời thầu] Thuê ngoài Dịch vụ phát triển phần mềm Hệ thống quản lý văn bản điện tử phục vụ nâng cấp SPDV

![[Mời thầu] Gói thầu số 01: Thuê dịch vụ phần mềm quản lý y tế cơ sở của Trung tâm y tế huyện Thạch Thất](/assets/news/2024_03/goi-thau-so-01-thue-dich-vu-phan-mem-quan-ly-y-te-co-so-cua-trung-tam-y-te-huyen-thach-that.png) [Mời thầu] Gói thầu số 01: Thuê dịch vụ phần mềm quản lý y tế cơ sở của Trung tâm y tế huyện Thạch Thất

[Mời thầu] Gói thầu số 01: Thuê dịch vụ phần mềm quản lý y tế cơ sở của Trung tâm y tế huyện Thạch Thất

Thông báo phát hành NukeViet 4.5.05

Thông báo phát hành NukeViet 4.5.05

![[Mời thầu] Gói thầu số 02: Nâng cấp phần mềm quản lý bệnh viện His của Bệnh viện đa khoa khu vực Ngọc Lặc](/assets/news/2024_03/goi-thau-so-02-nang-cap-phan-mem-quan-ly-benh-vien-his-cua-benh-vien-da-khoa-khu-vuc-ngoc-lac.png) [Mời thầu] Gói thầu số 02: Nâng cấp phần mềm quản lý bệnh viện His của Bệnh viện đa khoa khu vực Ngọc Lặc

[Mời thầu] Gói thầu số 02: Nâng cấp phần mềm quản lý bệnh viện His của Bệnh viện đa khoa khu vực Ngọc Lặc

![[Mời thầu] Cải tạo hạ tầng và CCDV Colocation cho Khách hàng VNPAY tại IDC Tân Thuận và IDC Nam Thăng Long](/assets/news/2024_03/cai-tao-ha-tang-va-ccdv-colocation-cho-khach-hang-vnpay-tai-idc-tan-thuan-va-idc-nam-thang-long.png) [Mời thầu] Cải tạo hạ tầng và CCDV Colocation cho Khách hàng VNPAY tại IDC Tân Thuận và IDC Nam Thăng Long

[Mời thầu] Cải tạo hạ tầng và CCDV Colocation cho Khách hàng VNPAY tại IDC Tân Thuận và IDC Nam Thăng Long